3月29日,非营利组织“未来生命研讨所(Future of Life Institute)”宣布了一封题为“暂停巨型AI试验”的公开信,呼吁全球的AI试验室暂停练习比GPT-4更强壮的体系至少6个月,并在此期间开宣布一份针对AI的同享安全协议,必要时需求政府介入。

1000多名科技人士在这份公开信上签名,包含特斯拉CEO马斯克、Stability AI的CEO Emad Mostaque等企业掌门人,也包含Alphabet旗下DeepMin的研讨人员,还有比如图灵奖得主Yoshua Bengio这样的重量级学者。当然,也有人表达了不同定见,以为这是在阻止技能进步。

开宣布GPT-4模型的OpenAI公司内还没有人签名,该公司目前也没有对这封公开信予以回应。但咱们向卷入纷争中的ChatGPT要了个回应。

这个AI自然言语大模型产品却是表现出了善解人意的一面:暂停试验存在合理性,但需求谨慎考虑这么做带来的技能发展滞后问题。它还给出了关于AI的六大危险和十个管理制度主张。

人类精英:暂停试验 树立规则

到今日,挂在“未来生命研讨所(FLI)“官网上的《暂停巨型AI试验》公开信,已经收集了1130人的签字,名单里精英聚集,不乏特斯拉、苹果等科技公司的高管,也有政客和作家,当年,更多的是全球多所高校的教授以及人工智能范畴的专家。

那么精英聚集签字的这封公开信究竟说了什么?以下是这封信的全文(向上滑动启阅)

广泛的研讨表明,具有能与人类比赛的智能的AI体系会对社会和人类构成深刻的危险,顶尖的AI试验室也供认这一点。正如广受认可的阿西洛马人工智能准则(Asilomar AI principles)准则所述,高档AI或许代表着地球生命前史的深刻改变,应该以适宜的态度和资源去进行规划和管理。不幸的是,这种水平的规划和管理并没有发生。尽管最近几个月AI试验室陷入了一场失控的比赛,以开发和使用越来越强壮的数字思想,然而没有人能够了解、猜测或可靠地操控这些思想,乃至他们的创造者也不能。

今世AI体系在一般使命上正在拥有与人类比赛的才能,咱们有必要问问自己:

咱们应该让机器在咱们的信息渠道中充满宣扬和谎话吗?

咱们是否应该自动化一切的作业,包含那些有成就感的作业?

咱们是否应该培养出或许比咱们数量更多、比咱们更聪明、终究超越并代替咱们的非人类思想?

咱们是否应该冒着失去对咱们文明操控的危险?

此类决议计划决不应该委托给未经选举产生的技能领导人。只有当咱们确信AI的效果是活跃的,危险是可控的时候,AI体系才应该被开发。这种对AI的判断有必要是合理的,并跟着体系潜在影响的改变而改变。

OpenAI最近关于人工通用智能(AGI)的声明指出,“在开端练习未来的体系之前,进行独立审查或许很重要。一起关于最前沿的作业而言,人们应该在适宜的时刻点限制用于创立新体系的计算增长率。咱们赞同这一说法,并以为现在便是适宜的时刻点。

因而,咱们呼吁一切的AI试验室当即暂停练习比GPT-4更强壮的AI体系至少6个月。这种暂停应该是公开的和可核实的,一切要害的参与者也能暂停相关作业。如果这种暂停不能敏捷开端,政府应该介入并实施暂停。

AI试验室和独立专家应使用这一暂停的时段,共同开发一套AI规划和开发的同享安全协议,这些协议需求由独立的外部专家严厉审计和监督。这些协议应确保一切恪守它们体系的AI是安全的。这种暂停并不意味着总体上暂停AI开发,仅仅让人们从具有新式功用的、不可猜测的危险比赛中撤退一步。

AI的研讨和开发应该重新聚焦于使当今强壮、最先进的体系愈加精确、安全、可解释、通明、稳健、共同、可信和可靠。

与此一起,AI开发人员有必要与政策制定者合作,大幅加速强壮的AI管理制度的开发。管理制度至少应包含以下内容:

◾针对AI的新的、有才能的监管机构;

◾监督和跟踪才能强壮的AI体系和计算才能池;

◾帮助区分真实和合成数据的溯源、水印体系,并跟踪模型走漏;

◾供给健全的审计和认证生态体系;

◾对AI形成的危害进行责任确定;

◾为AI技能的安全研讨供给足够的公共资金;

◾资源足够的机构以应对AI将形成的巨大经济和政治破坏(尤其是对民主的破坏)。

人类能够通过AI享用一个昌盛的未来。在成功创立了强壮的AI体系后,咱们现在能够享用一个“AI之夏”。

在这个AI的夏天,咱们能够收获报答,为一切人的利益规划这些体系,并给社会一个习惯的机会。人类社会曾经暂停使用一些或许会对社会形成灾祸性影响的技能,咱们现在也能够在AI范畴这样做。让咱们享用一个漫长的AI之夏,不要在没有准备的情况下匆忙进入秋天。

事实上,这封公开信是近期人类精英们对人工智能危险忧虑的总迸发。自 ChatGPT 高速迭代后,忧虑从未中止,特别是当微软、谷歌、百度、华为等科技巨头们在自然言语模型上展开“军备比赛”之后。

日前,“深度学习之父”杰弗里辛顿(Geoffrey Hinton)在媒体采访中表示,人工智能正处于“要害时刻”,毁灭人类“并非不或许”。AI范畴内的“大牛”盖瑞马库斯(Gary Marcus)发推特支持辛顿,乃至宣布灵魂一问:“用百分之一的人类毁灭危险换取和机器对话带来的趣味,这值得吗?”

而马库斯在转发FLI这封公开信时表示,“这封信并不完美,但精力是正确的。咱们需求怠慢脚步,直到咱们更好地了解AI带来后果……他们或许会形成严峻损伤……首要参与者对他们正在做的工作越来越保密,这使得社会很难抵挡或许发生的任何损伤。”

也有科技圈人士对这封信的观念持不同定见。

Writer的创始人Waseem 以挖苦的口气表达了他对权威们的不满,“让咱们中止建设和发展咱们的公司,由于来自硅谷的亿万富翁说咱们有危险。一定要喜爱那些比咱们人类更聪明的人,由于他们告知咱们如何生活。当咱们有他们神圣的指引时,谁还需求进步?”

OSS Capital的创始人Joseph Jacks 态度更是简洁明了:强烈对立,绝对不签这个。

ChatGPT:暂停合理但小心阻滞技能

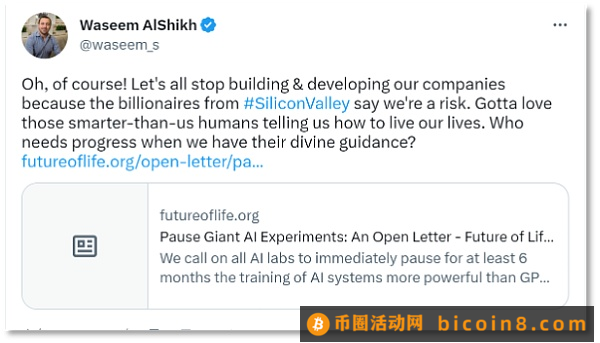

目前,OpenAI 还没有就 FLI 的这封公开信做出回应。而咱们把人类精英们的忧虑与主张甩给了ChatGPT,引发这场纷争的这个对话机器人不光认可了FLI要求暂停试验的合理性,还补充了六大AI危险。

ChatGPT的答案中也包含了暂停试验带来弊端:导致技能发展的滞后。这也和舆论场上许多普通群众的想法趋同。

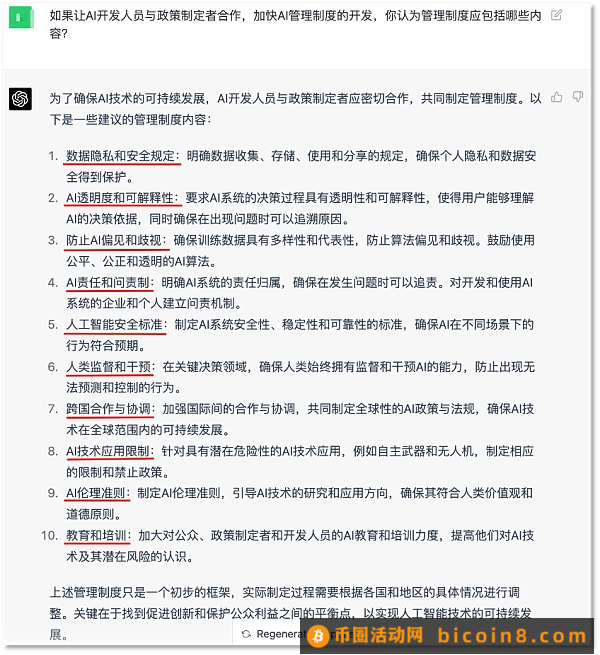

那么,问题摆在眼前,如果要让研讨人员和政府制定规则,该包含哪些内容呢?ChatGPT给出了十大主张,相当于给包含自己在内AI发展画了一个标准圈。

连ChatGPT自己都这么说了,可见,“AI失控”、”代替人类“无论是在定见领袖圈层仍是舆论场上都有探讨的含义。

最近,微软的创始人比尔盖茨在大力肯定人工智能带来生产力提高的一起,也强调过危险,“AI失控的或许性是存在的,一台机器会以为人类是自己的要挟吗?它们会得出结论以为本身利益与人类的利益不同从而不在意咱们吗?” 他猜测,跟着算法、算力的提高,超级智能AI会在未来出现。

连 OpenAI 的CEO Sam Altman都表示,超级智能AI的危险或许会远远超出咱们的意料。此前,他在技能研讨员Lex Fridman的播客中表达他的忧虑,包含AI形成的虚假信息问题,带来的经济冲击等等,“危害或许远远超越了人类能应对的程度”,他举了个例子,“咱们怎么会知道,大言语模型没有在推特上指挥大家的思想活动呢?”

这正应了那封公开信中所说的:没有人能够了解、猜测或可靠地操控这些数字思想,“乃至他们的创造者也不能”。

尽管通用人工智能(AGI)还远远没有到来,但就像比尔盖茨说得那样,在这之前,世界需求树立规则以使AI带来的正面影响远远超越其负面影响。

换句话说便是,别让人类造出的东西把人类自己灭了。毕竟,战争、核事故带来的灾祸还记忆犹新。

此时快讯

【2023-03-30 14:51】【报告:产品与开发类DAO在2022年获得了最多的资金支持】3月30日消息,区块链研究机构 Messari 发布的 DAO 资金状况研究报告显示,随着 DAO 的发展,许多 DAO 采用了工作组结构来分配内部劳动力。在涵盖的 10 个 DAO 整个 2022 年中,从 DAO 的财库中分配了 1.02 亿美元用于内部 DAO 劳动力。其中超过 58% 的资金用于产品和开发费用,第二大类别是增长(22%)。每个类别及其具体组成对于确定 DAO 的长期成功起着至关重要的作用。

报告还表示,为了在吸引和留住顶尖人才方面保持与传统组织的竞争力,DAO 应探索创新的资助方法。