作者:追一科技

来历:机器之心

本文全方位地介绍了 ChatGPT 的才干特征、开展进程以及 OpenAI 一路走来所据守的技能道路,并对 ChatGPT 呈现之后 NLP 范畴的范式转换进行了展望,即 ChatGPT 敞开「文本生成 + 指令」的范式。

1、ChatGPT,不再「愚笨」的人工智能

ChatGPT 的相关话题应该算是继 AlphaGo 以来,最出圈的人工智能热点了。简略来说,它是一个能够用天然言语对话的机器人,你能够问它任何问题(当然它有或许会答错,但你能够引导并纠正它),它都会以十分流通、标准的天然言语答复你。不仅如此,它还能答复代码问题、数学问题等等,你能够和它在关于任何问题上聊得不亦乐乎。

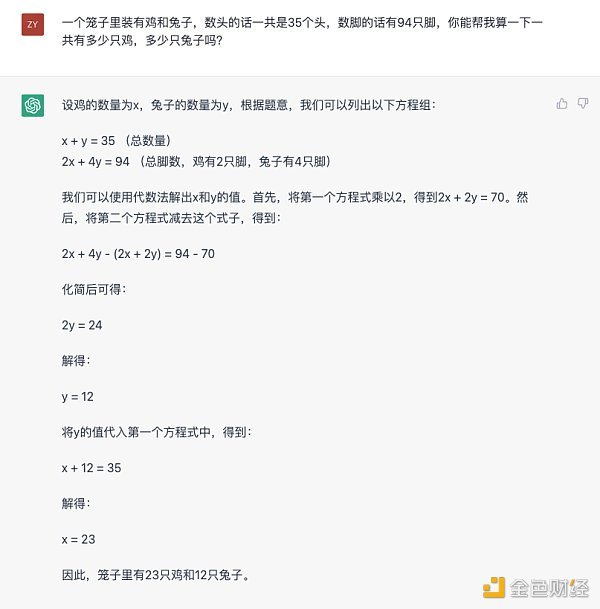

咱们能够用一个经典的鸡兔同笼问题来感性地知道一下 ChatGPT 的才干:

从这个答复能够观察到几个特点。首先是对天然言语的了解和转换为数学问题的才干,其次它经过将一个较为杂乱的推理问题分步拆解,一步步取得最终的答案。这个才干被业界称作「思想链」(Chain of thought)。接下来换一下问法,看看它会怎样答复。

从这个图中能够发现,ChatGPT 对自己所说的内容是有感知的,而且能够给出这么说的原因。别的也能够发现,它的确也会犯错(榜首次计算耳朵数量错了。此处有个冷常识,鸡是有相似于「耳朵」相同的功用器官),但能够经过引导的办法让它给出正确的答案,而且会告知你自己为什么错了。

假如不事前告知你这是一个人工智能模型,ChatGPT 给人的感觉的确像一个实在有逻辑思想和言语沟通才干的真人。它的呈现榜首次让咱们觉得,人工智能好像总算能够和人正常沟通了,尽管有时分会犯错,但在沟通的进程中至少没有言语和逻辑上的妨碍,它能「懂」你在说什么,而且依照人类的思想模式和言语标准给你反应。这种十分智能的体会感,是它突破业界小圈子,给群众带来冲击感的原因。

这儿还期望再次着重这种体会感的问题,由于或许曩昔业界由于技能的限制,为了完结场景中的特定使命而忽略了这一点。现在 ChatGPT 的呈现代表了人工智能不再是曩昔那种「有用,可是也挺蠢」的形态了。

为了更好地了解 ChatGPT 这种十分智能的感觉是怎样发生的,不免要从曩昔那种「很蠢」的人工智能说起。精确地说,ChatGPT 背后运用的仍然是天然言语处理(NLP)技能,但却打破了原有的范式。

要了解这一点,能够先看看现在的主流做法是怎样的。人类沟通依托的是言语,乃至也有许多人以为人类的思想也是建立在言语上的。因而,了解运用天然言语一向是人工智能的重要课题。但言语实在太杂乱,因而为了让计算机了解运用言语,一般会将这个进程拆分为许多的细分项,这便是在技能范畴中常说的「使命」。举几个比方:

-

情感剖析使命,针对的是了解言语所包含的情感倾向;

-

句法剖析使命,针对的是剖析文本的言语学结构;

-

实体识别使命,针对的是从文本中定位出实体片段,例如地址、名字等等;

-

实体衔接使命,针对的是从文本中抽取出实体间的联络;

这样的使命还有许多,都是从某个细分的旁边面去对天然言语进行剖析、处理。这样做有许多优点,比方有了这些拆分,就能够从不同的维度来调查一个天然言语处理体系的细分才干;也能够针对某一个细分的项专门做体系或许模型的规划等。从技能的视点来说,将一个杂乱的使命(了解并运用天然言语)拆分为许多的简略使命(各式各样的 NLP 使命)的确是一种比较典型的处理杂乱问题的途径,这也是现在的主流做法。然而在 ChatGPT 呈现之后,以马后炮视角去看,或许在让计算机了解并运用天然言语这条路上,这种拆分并不是最有用的途径。

由于在单个使命上的优异体现,并不能代表体系就把握了天然言语。人关于人工智能体的「智能感」,是依据对它运用天然言语的全体才干而发生的,这一点在 ChatGPT 上有显着的体现。尽管 OpenAI 没有敞开 ChatGPT 的 API 服务,外界还无法测评它在各个细分 NLP 使命上的详细作用,但以过往外界对它的前身 GPT-3、InstructGPT 等模型的测试状况标明,关于某些特定的使命,一个用专门数据精调过的小模型,的确能够取得更好的作用(详细剖析请参阅《深入了解言语模型的突现才干》)。但这些在单个使命上有更好体现的小模型,并没有引起很大的出圈效应。归根究竟,是由于它们只要单一的才干。单个的才干出众并不能代表它们具有了了解和运用天然言语的才干,然后也无法单独在实践运用场景中发挥作用。正因如此,一般在一个实在的运用场景中,都是多个具有单点才干的模块经过人为的规划凑集而成,这种人为的凑集办法是曩昔的人工智能体系让人感觉并不智能的原因之一。

从人类了解和运用天然言语的视角去看,这个现象其实很好了解。一般人在了解、运用天然言语的时分,并不会在脑内将它拆分为许多步不同的使命,逐一使命进行剖析,然后再汇总,这不是人类运用天然言语的办法。就好比一个人,在听到一句话的时分,并不会对它的句法结构、实体内容与联络、情感倾向等这些内容逐一剖析,然后凑集出这句话的含义,人对言语的了解进程是一个全体进程。再进一步,人对这句话的全体了解,会以天然言语的办法,经过回复的办法全体地体现出来。这个进程并不是像人工智能体系那样,拆分单个使命,然后逐一输出情感剖析的标签、实体信息的片段、或是其他某个单个使命的成果,然后用这些东西凑集出回复。

而以 ChatGPT 为代表,GPT 系列模型所做的作业才实在接近了人类了解和运用言语的才干 —— 直接接收天然言语,然后直接回复天然言语,并保证了言语的流通性与逻辑性。这是人与人的沟通办法,所以咱们对它抱以「很智能」的体会感。或许许多人会以为,假如能做到 ChatGPT 这样当然很好,曩昔那种对使命的拆分是由于技能的限制不得已而为之。从技能运用的视角来看,这样迂回的办法当然是需求的,这种办法也在很长的一段时刻内被选用,而且的确也能够处理许多实践场景中的问题。但假如回忆 GPT 系列模型的开展进程,就会发现 OpenAI「赌」了另一条路,而且他们「赌」赢了。

2、OpenAI 的「赌局」

GPT 初代,全部开端的地方

早在 2018 年,OpenAI 就发布了最初版本的 GPT 模型,从 OpenAI 揭露的论文(Improving Language Understanding by Generative Pre-Training)能够了解到,这个模型选用了 12 层的 Transformer Decoder 结构,用了大约 5GB 的无监督文本数据进行言语模型使命的练习。尽管初代 GPT 模型选用的就现已是生成式的预练习(这也是 GPT 名字的由来,Generative Pre-Training,即生成式预练习),但运用的是无监督预练习 + 下流使命微调的范式。这一范式其实并不是什么新的创造,它在 CV(计算机视觉)范畴现已有比较广泛的运用,仅仅由于当年 ELMo 模型的超卓体现,把它从头「介绍」到了 NLP 范畴。

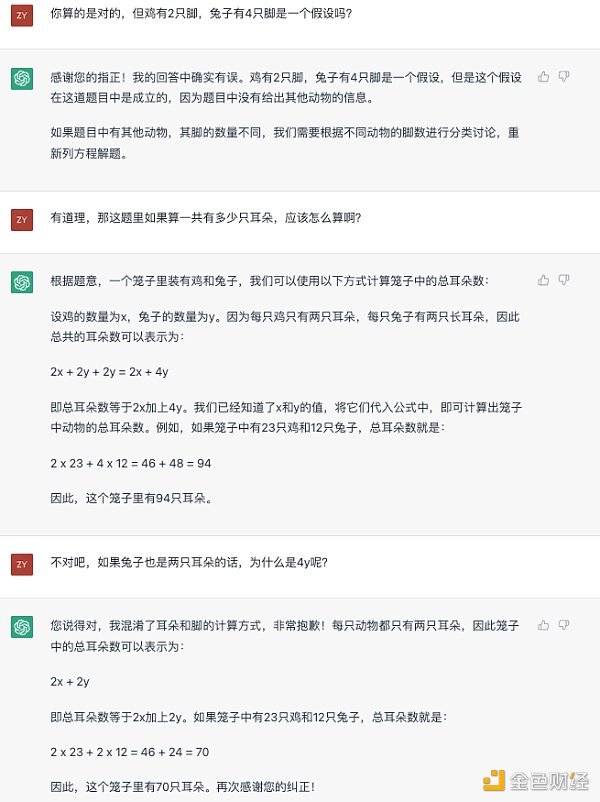

GPT 模型的呈现在那一年的确引来了一些业界的重视,但它并不是那一年的 C 位主角。由于就在同年,Google 的 BERT 模型横空出世,以优异的作用吸引了简直全部的目光(这个景象有点像现在的 ChatGPT,不禁感叹 Google 和 OpenAI 之间的「恩恩怨怨」真是天道好轮回)。

图片来自 BERT 论文,从图示中能够一窥当年 BERT 对标的便是 GPT,并引以为傲地指出双向编码才干。

BERT 模型尽管也是选用和 GPT 相同的 Transformer 模型结构,但它简直便是为「无监督预练习 + 下流使命微调」的范式量身定制的模型。和 GPT 比较,BERT 所运用的掩码言语模型使命(Masked Language Model)尽管让它失去了直接生成文本的才干,但换来的是双向编码的才干,这让模型具有了更强的文本编码性能,直接的体现则是下流使命作用的大幅提高。而 GPT 为了保存生成文本的才干,只能选用单向编码。

以当年的眼光来看,BERT 绝对是一个愈加优异的模型。由于既然 BERT 和 GPT 两者都是选用「预练习 + 微调」的范式,而且下流使命仍然是分类、匹配、序列标示等等「经典」的 NLP 使命办法,那么像 BERT 模型这种更注重特征编码的质量,下流使命选一个适宜的损失函数去合作使命做微调,显着比 GPT 这种以文本生成办法去「迂回地」完结这些使命愈加直接。

从 BERT 模型出来今后,「无监督练习 + 下流使命微调」的范式便奠定了它的霸主位置,各类沿着 BERT 的思路,揣摩「怎样取得更好的文本特征编码」的办法许多呈现,以至于 GPT 这个以生成式使命为方针的模型显得像一个「异类」。马后炮地说,假如其时 OpenAI「适应大势」,抛弃生成式预练习这条路,或许咱们要等更长的时刻才干见到 ChatGPT 这样的模型。

GPT-2 带来的期望

当然,咱们现在见到了 ChatGPT,所以 OpenAI 没有抛弃生成式预练习的道路。实践上坚持的「报答」隐约呈现在了第二年,也便是 2019 年。OpenAI 发布了有 48 层 Transformer 结构的 GPT-2 模型。在发布的论文(Language Models are Unsupervised Multitask Learners)中,他们发现经过无监督数据合作生成式练习后,GPT 展示出了零样本(zero-shot)的多使命才干。而美妙的是,这些多使命的才干并不是显式地、人为地参加到练习数据中的。用浅显的话来举个比方,GPT-2 其间一个展示出来的才干是做翻译,但令人吃惊的是,一般专门用来做翻译的模型是需求许多的平行语料(即两种不同语种之间配对的数据)进行监督练习,但 GPT-2 并没有运用这种数据,而仅仅是在许多的语料上进行生成式的练习,然后它就「忽然」会做翻译了。这个发现或多或少地带有点颠覆性的意味,它向人们展示了三个重要的现象:

-

想让模型去完结一种 NLP 使命,或许并不需求和使命匹配的标示数据。例如 GPT-2 练习时没有用标示的翻译数据,但它会做翻译;

-

想让模型去完结一种 NLP 使命,或许并不需求和使命匹配的练习方针。例如 GPT-2 练习的时分并没有规划翻译使命和相关的损失函数,它仅仅在做言语模型使命。

-

仅仅用言语模型使命(即生成式使命)练习的模型,也能够具有多使命的才干。例如 GPT-2 展示出了翻译、问答、阅览了解等等的才干。

尽管以现在的眼光来看,其时的 GPT-2 所展示出来的各种才干还比较初级,作用间隔运用监督数据微调后的一些其它模型还有显着的间隔,但这并没有妨碍 OpenAI 对它所包含的潜在才干充满等待,以至于在论文摘要中的最终一句话中,他们提出了对 GPT 系列模型未来的期望:

“These findings suggest a promising path towards building language processing systems which learn to perform tasks from their naturally occurring demonstrations.”

后来一系列作业的开展也证明晰他们的确是一向朝着这个 promising path 的方向在行进。假如说在 2018 年,GPT 初代模型出来的时分,GPT 的生成式预练习还面对着被 BERT 这类以「提取特征」为目地的预练习模型在各方面碾压,那么在 GPT-2 中的发现,给了生成式预练习一个 BERT 类模型无法替代的潜在优势,即言语模型使命所带来的多使命才干,且这种多使命才干是无需标示数据的。

当然,在那个时刻点上,生成式的技能途径仍然面对危险和应战。究竟其时的 GPT-2 在各使命上的体现仍是差于经过微调的模型,这导致了 GPT-2 尽管有着翻译、摘要等等才干,但作用太差以至于无法实践运用。因而,假如在其时想要一个可用的翻译模型,最好的挑选仍然是老老实实用标示数据练习一个专门用来翻译的模型。

GPT-3,数据飞轮的开端

从 ChatGPT 年代往回看,或许 OpenAI 在 GPT-2 中的发现的确坚决了他们对 GPT 系列模型的信心,并决定加大研制投入力度。由于在随后的 2020 年他们发布了 1750 亿参数量的 GPT-3,一个即使以现在的眼光去看也大得让人惊叹的模型。尽管 OpenAI 没有清晰揭露练习这个模型的费用,但咱们的估算是其时花了 1200 万美元。一起揭露的还有一篇长达 60 多页的论文(Language Models are Few-Shot Learners),其间详细论述了这个新的庞然巨物所展示出来的新才干。最重要的发现莫过于论文标题中所说的,言语模型具有小样本(few-shot)学习的才干。

小样本学习是一个机器学习范畴的专业术语,但它有着很朴素的理念,即「人类是能够经过少数的几个比方就学会一个新的言语使命」。幻想一下在语文课上学习怎样把握「把」字句换成「被」字句样(雨把衣服淋湿了 —— 衣服被雨淋湿了)的情形,老师会给出几个比方,同学们就能够把握这项才干。

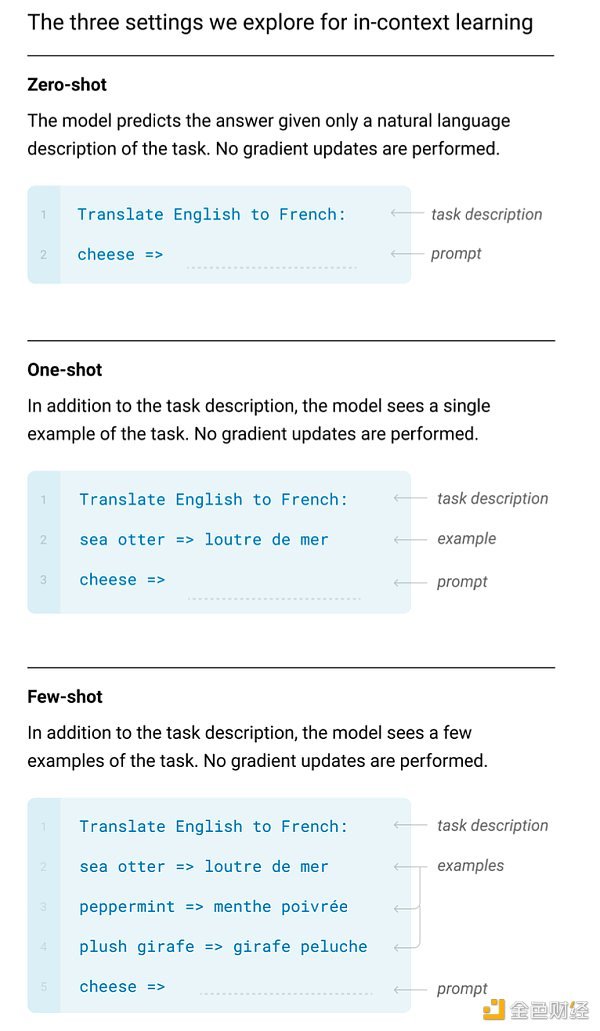

但关于深度学习模型来说,它一般需求学习(练习)不计其数的比方才干把握一项新的才干,但咱们发现 GPT-3 却像人类相同具有相似的才干。而且重点在于,只需求给它展示几个比方,它就会「有样学样」地完结比方给出的使命,而不需求进行额定的练习(即不需求进行惯例练习中的梯度反传和参数更新)。后来的研讨标明,这种才干是巨型模型所特有的,被业界叫做「在上下文中学习」(in context learning)的才干。

GPT-3 论文中所展示的英语翻译法语的 In context learning 才干。

实践上,小样本学习才干自身并不是很惊人的发现。究竟业界一向都在对小样本学习进行研讨,许多专攻小样本学习的模型都有超卓的小样本学习才干。但 GPT-3 展示出来的这种「在上下文中学习」的小样本才干却十分出人意料,其原因也和 GPT-2 所展示的多使命才干相同:

-

GPT-3 并没有为了取得小样本的才干而在练习数据、练习办法上做特其他规划,它仍然仅仅一个用言语模型使命练习的生成式模型;

-

GPT-3 的小样本才干是以「在上下文中学习」的办法展示出来的。换句话说,想让它取得新的才干,不需求对它再练习,而只需求给它看几个示范的比方。

除了这个才干以外,GPT-3 还展示出了优异的文本生成才干,比较 GPT-2,它生成的内容愈加流通,而且能够生成很长的内容。这些才干综合体现在一个模型上,让 GPT-3 在其时成为了咱们的重视焦点,它也成为 OpenAI 正式对外供给服务的模型。

但跟着这个模型服务的敞开,越来越多的人测验运用这个模型。从这时起,OpenAI 经过敞开给公众的办法,一起也在搜集着更具有多样性的数据(用户运用时输入的内容或许会被用于模型的练习,这一点是写在用户条款中的),这些数据在后来的模型迭代中也发挥着重要的作用。自此 GPT 系列模型的数据飞轮便转动了起来,越多优质的用户数据,迭代出作用越好的模型。

与 ChatGPT 不同的是,GTP-3 并不是选用对话的办法交互的模型,而是一个文本的续写模型(也便是在你输入的文字后边接着往下写),因而它并不具备现在的 ChatGPT 所具有的多轮对话才干。但它现已能够干许多的作业,例如编写故事、给邮件做主动补全等等。但一起,咱们也渐渐发现了一些问题,例如它会不苟言笑地输出不契合现实的内容,而且会输出一些有害的言辞等等。这是这种文本生成模型最杰出的坏处,尽管经过多次迭代,但 ChatGPT 现在也仍然面对相似的问题。

CodeX,让计算机自己写代码

OpenAI 在对 GPT-3 的研讨中还有一个意外的发现,它能够依据一些注释生成很简略的代码。因而在随后的 2021 年,他们对生成代码这件作业进行了专门的研讨投入,并发布了 CodeX 模型。它能够看作是一个有着代码专精才干的 GPT 模型,能够依据天然言语输入生成比较杂乱的代码。

从外部视角来看,咱们无法判别代码生成的研讨与 GPT 系列模型的研制是否在一起进行。但放在其时,让模型具有生成代码的才干,从实用化的视点来说的确愈加具有含义,究竟 GPT-3 还未具有现在 ChatGPT 这般强悍的才干。另一方面,让模型去生成代码也能躲避它生成有损害文本内容带来的危险。

在 CodeX 论文中提及了几个关键,首先是让经过文本数据预练习的 GPT 模型在专门的代码数据(数据来自 github 的开源代码,一共 159G)上练习的确能够显着提高模型对代码的了解和输出才干。其次是论文顶用的是一个 120 亿参数的「小」模型,这个信息从旁边面反映出 OpenAI 内部除了对外敞开接口的 1750 亿参数的 GPT-3 模型外,还有其他不同巨细的模型版本。

而参加代码练习,让模型取得了解和生成代码的决定,原本的初衷或许仅仅期望 GPT 能够多一种运用场景。它看似与 GPT 系列模型在了解和运用天然言语的才干没有太大的联络,但依据后续的研讨(详细的剖析请参阅文章《拆解追溯 GPT-3.5 各项才干的起源》),添加对代码数据的练习很有或许触发了后来的 GPT 模型在天然言语上的杂乱推理和思想链的才干。

或许在 OpenAI 做 CodeX 之初并没有预料到会有这样的成果,但就像他们一向运用文本生成使命来做 GPT 模型,然后在 GPT-2 和 GPT-3 中「解锁」了「多使命的才干」和「在上下文中学习的才干」那样,代码数据的引进又一次让他们取得了意料之外的收获。尽管看上去好像有一些偶尔,但对技能道路的前瞻性认知,加上坚持与持续的投入显着是一个至关重要的要素。

InstructGPT,让 GPT 好好说话

在前面咱们说到了 GPT-3 尽管现已有很强的才干,但上线今后跟着运用的人越来越多,也发现了许多问题,最严重的应该要数「不苟言笑地胡言乱语」和「输出带有损害性的内容」这两点了。尽管在 2021 年 OpenAI 好像暂时将重点放在了让模型了解和生成代码这件作业上,但他们应该一向在测验处理 GPT-3 的这些问题。

在 2022 年头,OpenAI 发表了 InstructGPT 的论文(Training language models to follow instructions with human feedback),从中咱们能够一窥处理这些问题的办法。论文的中心理念是让模型接受人类的教导(反应),这一点在标题中就现已开宗明义了。

GPT-3 之所以会呈现「不苟言笑地胡言乱语」和「输出有害的内容」这样的问题,其根源来自于它所运用的练习数据。像 GPT-3 这样的庞然大物,对数据的需求量是海量的。咱们从 GPT-3 的论文中能够找到它的数据来历,大致能够划分为三类:网页内容、百科内容以及书本。尽管网页内容的量十分大,但也十分「脏、乱、差」,天然会包含许多非实在性和有害的内容。GPT-3 在这些数据上进行练习,天然也就学到了这些东西。

但作为一款对外供给服务的产品,GPT-3 的答复应该更小心一些。要处理这个问题,其间的一难点在于怎样去定义模型应该怎样说话。由于生成模型的输出内容是天然言语自身,而不是一个分类的标签或一个实体名词这种有清晰的、客观对错的内容。没有清晰的对错,就导致无法像练习经典的 NLP 模型那样直接针对方针规划练习使命。

而 InstructGPT 给出的处理思路是十分直接的,既然关于「好的答复」这个点评目标有许多不同的影响要素,这些要素又相互交织在一起,那就让人来教它怎样写答复。由于人类是比较善于处理这种「既有清晰的要求,又有含糊的规模」的问题的,让真人写一些「优异典范」,让模型去学习这些「优异典范」,这正是 InstructGPT 提出的整体思路。

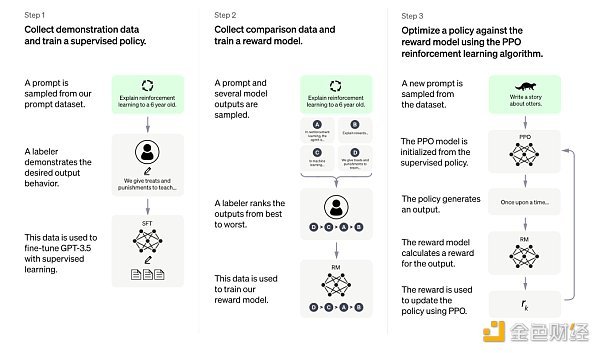

详细而言,InstructGPT 提出了两个阶段的途径来让 GPT 学习人类给出的「优异典范」,榜首阶段是监督学习,第二阶段是强化学习。在榜首阶段中(对应下图中最左面的 Step 1),让真人依据不同的 Prompt(浅显能够以为是咱们运用 ChatGPT 时,在对话框里输入的那条文本,在业界这个东西叫做指令)写实在的、无害的、有用的答复。实践操作进程中,为了保证这些内容的质量,会给写答复的标示人员一些标准性的指引,然后让现现已过预练习的 GPT 模型在这些人类编辑的数据上持续练习。这一阶段能够看作是对模型的一种「规训」,用一个不谨慎的类比来说,就像语文老师让你默写优异范文那样。

图片来自 InstructGPT 论文,提出经过监督式的指令微调 + 人类反应的强化学习来让模型的输出变得合理。

第二阶段是强化学习,技能上分为两步。榜首步(对应上图中心的 Step 2)是让被「规训」后的模型依据不同的 Prompt 生成多个不同的答复,并由人来给这些答复依照好与差的标准来排序。然后用这些标示了优劣之分的数据练习一个打分模型,让它能够主动给更多的数据进行排序打分。强化学习阶段的第二步(对应上图中右边的 Step 3)便是使用这个打分模型作为强化学习中的环境反应,以策略梯度(Policy Gradient,精确地说是 PPO 算法)的办法对现已「规训」后的 GPT 模型进行练习。整个第二阶段的进程能够看作是对模型的一种「强化」,再用一个不谨慎的类比来说,就像语文老师给你写的作文打分,让你从分数中分辩什么是好与欠好,然后不断前进。

因而,用一种十分不谨慎,但一般人或许也能够了解的办法来说,InstructGPT 先是让一个「口无遮拦」的 GPT 经过「默写人类的优异范文」的办法初步学会「好好说话」,然后再「给它单独写出来的东西打个分,让它回去好好领会,持续前进」。当然,在技能上牵涉作业会更杂乱一些,比方「优异范文」的详细标准和数量等数据上的问题,以及强化学习中打分模型的挑选,算法参数的设置等算法上的问题,都会对最终的作用发生影响。但最终的成果标明,这种办法是十分有用的,论文中也指出一个经过上述办法练习出来的 13 亿的小模型,作用就能够超越没有经过这种练习的更大的模型。

别的论文中还有一些十分值得一提的内容。首先是关于 Prompt 的一些发现。InstructGPT 练习时所运用的 Prompt 主要由两部分构成,一部分是专门的 AI 练习师编写的,另一部分自来 OpenAI 的模型在线服务期间,由用户运用中编写的内容,这时数据飞轮的作用就体现了。能够发现,无论是哪种,这些 Prompt 都是由真人写出来的,尽管文章中没有对这些 Prompt 的详细包含规模、散布状况以及提问的办法展开详细的剖析,但能够合理地猜想这些 Prompt 具有必定的多样性和较高的质量。其实文章中对比了运用这些真人编写的 Prompt 练习的模型和运用一些开源 NLP 使命数据集中构建的 Prompt(例如 T0 数据集、FLAN 数据集)练习出来的模型,结论是由真人编写 Prompt 练习出来的模型,给出的答案愈加能被评测的人接受。

别的一点是关于练习好的模型对新的 Prompt 的泛化才干的问题,可想而知的是,假如练习完结的模型无法发生 Prompt 的泛化才干,那么现在 ChatGPT 所体现出来的,简直百问百答的才干是不太或许发生的。由于在模型做微调的阶段,即使是再多的数据,也不或许把人们有或许会输入的内容都掩盖完整。而 InstrctGPT 论文中点明晰文中所选用的办法是能够发生 Prompt 的泛化才干的。

之所以花了更多的文字对 InstructGPT 做介绍,由于依据 ChatGPT 官方页面的介绍,InstructGPT 中的办法正是用来练习 ChatGPT 的办法,不同的仅仅 ChatGPT 运用了对话式的数据安排办法。

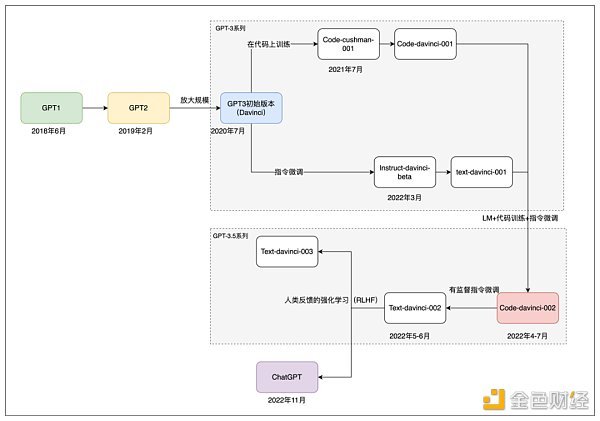

GPT-3.5 年代和 ChatGPT 的诞生

在随后的时刻内,OpenAI 发布了多个被称为 GPT-3.5 系列的模型,尽管这些模型并未有相关的论文跟从发表,但依据这篇文章的剖析,GPT-3.5 系列应该是交融了 OpenAI 在 GPT-3 年代积累的技能、数据以及经历开发出来的。由于没有详细的官方揭露信息参阅,关于这些模型的详细材料,外界主要是经过剖析运用的体会、相关的技能论文以及 OpenAI 的 API 文档介绍来进行估测。

依据剖析,GPT-3.5 系列的模型有或许并不是在 GPT-3 上持续微调而来,而很或许是将代码和天然言语的数据交融在一起,从头从零开端练习了一个根底模型。这个模型或许比 GPT-3 的 1750 亿参数量更大,它在 OpenAI 的 API 中被命名为 codex-davinci-002。然后在这个根底模型上,经过指令微调和人类反应得到了一系列后续的模型,包含 ChatGPT。

GPT 系列模型的开展途径。

简要地说,从 code-davince-002 这个模型开端,经过有监督的指令微调得到 text-davinci-002。以及后续的 text-davinci-003 和 ChatGPT,也是在 GPT-3.5 系列的某个模型上经过指令微调以及人类强化学习反应得到的。而且 text-davinci-003 和 ChatGPT 都是在 2022 年 11 月发布的,不同的是 text-davinci-003 和 GPT-3 相同,是一个文本补全模型。而依据 ChatGPT 的官方介绍,它是经过将过往的数据处理成对话交互的办法,并添加了新的对话数据练习出来的。

至此,咱们大致回忆了 OpenAI GPT 系列模型从 2018 年的初代 GPT 到现在的 ChatGPT,一路开展迭代的进程。在这个进程中,OpenAI 一向保持着对生成式预练习模型这一技能途径的「执拗」,而且也一向从不断开展的 NLP 技能中吸纳新的办法,从最初的 Transformer 模型结构,到后来的指令微调(Prompt tuning)等技能的呈现,这些要素共同促进了现在 ChatGPT 的成功。有了对 GPT 系列模型开展的了解,咱们能够再回过头来看看现在的 ChatGPT。

3、走近再看 ChatGPT

在榜首章节中咱们论述了 ChatGPT 出圈的原因主要是:「它以流通、契合逻辑的天然言语来反应人类对它输入的天然言语」,然后给与它沟通的人带来了很强的「智能感」。在第二章节中经过回忆 GPT 系列模型的开展历史来了解 ChatGPT 成功之路。而这一章节会测验以尽或许让圈外人都能了解的办法,略微深入一些技能的内容,而且探讨一下当时的一些大型文本生成式模型为什么未能做到相同的作用。这一部份的主要参阅来自于《深入了解言语模型的突现才干》和《拆解追溯 GPT-3.5 各项才干的起源》这两篇文章以及相关的一些论文,建议期望详细了解细节的读者阅览原文。

尽管在榜首章中指出,ChatGPT 所带来的冷艳作用是由许多不同的 NLP 使命综合体现出来的,但在剖析它背后的技能时,仍是经过将它的才干进行拆解会愈加清晰明晰一些。整体而言,ChatGPT 所体现出来的才干能够大致划分为以下几个维度:

- 文本生成的才干:ChatGPT 的一切输出都是即使生成出来的文本,所以文本生成的才干是它最基本的要求。

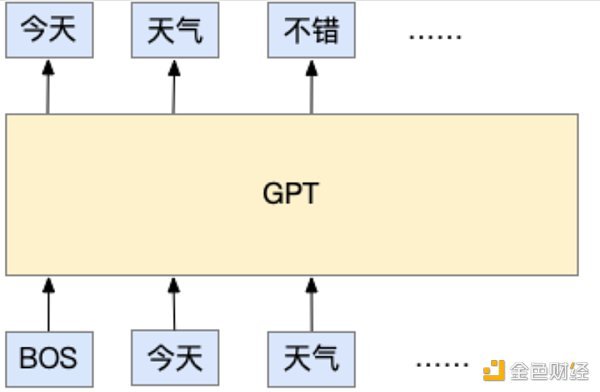

这一项才干实践上是来自于它的练习办法,ChatGPT 在预练习时,是一个标准的自回归言语模型使命,这是 OpenAI 一切 GPT 系列模型的基底。所谓的自回归言语模型使命,浅显的了解是这样的:它能够依据现已输入的文本,猜想下一个 token 应该是什么。这儿所说的 token,所代表的是模型所运用的最小单位的字符片段,它能够是字(在中文里选用字是很常见的),也能够是词(英文的每个词天然地被空格隔开了,所以常选用词),乃至是字母。但现在的办法一般选用的是子词(subword,介于字母和词之间,主要的意图是减少词表数量)。但不论是哪种,自回归言语模型使命的基本思路都是依据现已输入的文本,猜想下一个要输出的文本是什么,就像下图的比方中那样:

这个比方中,BOS 代表了输入的最初,而每个 token 是一个词,GPT 模型依据输入的「今天」和 「气候」两个词,猜想下一个要输出的是「不错」。

在练习的时分,会准备许多文本数据,比方网页上的文章、各类书本等等,只要是正常的文字内容,都能够用来练习。值得说明的是,这种数据不需求进行额定的人工标示,由于这类数据原本便是人写的,模型要做的作业便是依据这些人写出的文本,去学习「给定了前面的文字,接着这些文字后边这个地方应该是什么」的问题。这便是业界所称的「无监督练习」,实践上模型并不是真的没有监督(不然模型学什么呢?),仅仅它的数据不需求额定的人工标示。也正由于这个使命是不需求额定标示的,因而能够「免费」取得许多的数据,得益于互联网的普及,能够「轻松地」取得海量的由真人写出的文本内容用来练习。这一点也是 GPT 系列模型的特点之一,用海量的数据,去练习很大的模型。

那么在咱们运用 ChatGPT 的时分,它是怎样作业的呢?其实也和它的练习办法相同,模型会依据咱们在对话框里输入的内容,去猜想接在这些内容的下一个 token 是什么,得到这个 token 后,会将它与前面的内容拼接成一个新的文本给模型,模型再猜想下一个 token,如此重复,直到满足某个条件后中止。这个中止的条件有许多不同的规划办法,比方能够是输出的文本到达特定的长度,又或许是模型猜想出某个用来代表中止的特别 token。别的值得一提的是,模型猜想下一个 token 时,其实背地里是一个采样的进程。换句话说,模型在猜想 token 时,输出的其实是一切或许呈现的 token 的概率,然后从这个概率散布里采样一个 token。因而,在运用 ChatGPT 时,会发现即使关于相同的输入,它的输出每次也会不相同,由于在背地里它采样了不相同的 token 作为输出。

了解这些之后,能够再回过头来思考一下模型在学什么。它在学习怎样答复问答吗?又或许说它在学习怎样了解天然言语所包含的信息、逻辑、情感?仍是说它在学习海量的常识?从练习使命的规划来看,好像都没有,它仅仅从海量的文本数据里,学习了「依据输入的这些文本,一个人类在后边会接着写什么」这件事。但正是这样的模型,在「进化」到 ChatGPT 时,它却把握了丰厚的常识、杂乱的逻辑推理等等,它好像把握了一个人类运用言语所需求的简直一切的才干。这是一件十分奇特的作业,它的「进化」进程将会在下一章节中做愈加深入的介绍。

- 丰厚的常识储备:ChatGPT 能够正确答复十分多的问题,包含历史、文学、数学、物理、编程等等。由于现在版本的 ChatGPT 并没有使用外部常识,因而这些常识的内容是「储存」在模型内部的。

ChatGPT 所具有的丰厚常识储备,来自于它的练习数据,以及它满足大的体量,以便学会这些内容。尽管官方并没有揭露 ChatGPT 所运用的练习数据的详细细节,但从它的前身 GPT-3 的论文能够估测,这些数据大致能够分为三个大的范畴:网页内容、书本内容以及百科内容。可想而知的是,这些内容天然地包含了许多的常识,百科和书本天然不必说,而网页内容也包含了许多新闻、评论、观点等,而且网页也包含了许多专门的问答垂直类网站,这些都是 ChatGPT 的常识来历。在官方的介绍里指出 ChatGPT 无法答复 2021 年今后发生的作业,因而合理的猜想是练习的数据搜集截止到 2021 年。

但数据量仅仅其间一个方面,要让模型「把握」这些数据,其自身的体量是不或许小的。以 GPT-3 为例,它有 1750 亿参数,能够浅显地了解为,这些数据的内容以及模型的各项才干,都以这一个个参数的详细数值的办法,固定在了练习完结的模型中。感性的了解是,假定一个模型只要 1 个参数,那它什么也干不了。更谨慎的剖析和对比能够参阅这篇论文《Holistic Evaluation of Language Models》的测评,方向性的结论是越大的模型,在需求常识来完结的使命上体现得越好。论文地址:https://arxiv.org/pdf/2211.09110.pdf

- 逻辑推理与思想链的才干:从榜首章图片中的鸡兔同笼的比方能够看出,ChatGPT 具有很强的逻辑推理才干。而且它能够将杂乱的内容,经过拆解,分成多个小的步骤,一步步地进行推理,取得最终的答案,这种才干被称为思想链。

从前面的介绍咱们知道,模型在练习的时分并没有针对逻辑推理以及思想链做特定的规划。而当时的主流观点以为,逻辑推理和思想链很或许和两个要素相关,榜首个是模型的体量,第二个是模型是否在代码数据上进行过练习。

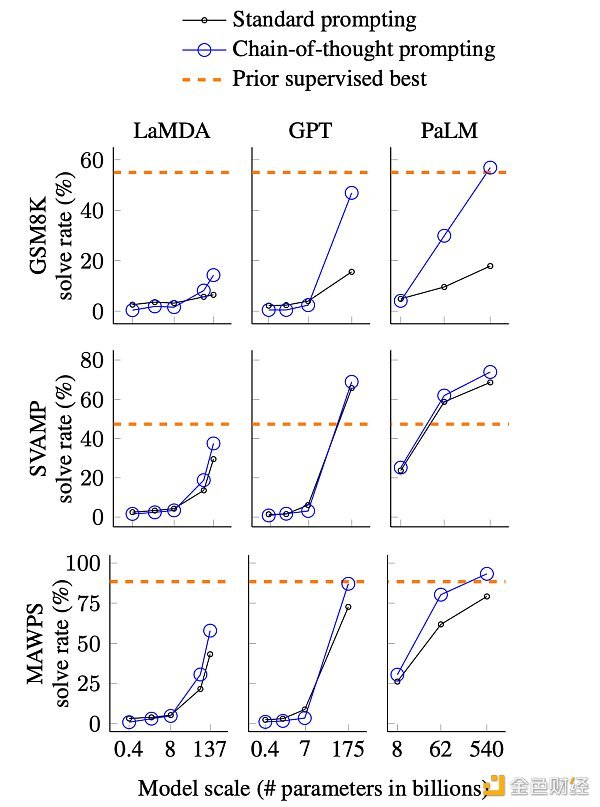

关于模型体量与推理、思想链才干的联络,在《深入了解言语模型的突现才干》中有对应的介绍。下面这张图展示了思想链才干与模型体量的联络。

不同模型不同尺寸的思想链作用对比,图来自论文。GSM8K,SVAMP 和 MAWPS 是三个需求逻辑推理的数学运用题数据集,LaMDA,GPT 和 PaLM 分别是 3 个不同的模型。

简要地说,图表中给出了三个不同的模型,在三个数学运用题数据集上的答对率。而值得重视的是以下几个方面:

-

思想链的才干(蓝色实线)在模型体量够大的时分发生了作用上的骤变;

-

思想链的才干在模型够大的前提下,作用超越了标准的指令(Standard prompting,黑色实线)办法;

-

思想链的才干在模型够大的状况下,能够接近乃至超越有监督的办法(橙色虚线)。

用浅显的话来说,便是在模型满足大的时分,思想链的才干忽然展示了出来,能够到达、乃至超越那些在推理数据集上专门进行有监督练习的模型。这个图或许部分解释了现在咱们看到的 ChatGPT 所具有的优异推理和思想链才干。

而另一个关于推理以及思想链才干的发生要素,与模型是否在代码数据上做过练习有关。现在这一点仅仅一个推论,《拆解追溯 GPT-3.5 各项才干的起源》中的剖析标明体量相似的大型模型,没有在代码上做过练习的话,只要很弱或简直没有思想链和推理才干。而 ChatGPT 的确是在代码数据上进行过练习的,这一点从它能够了解并生成代码也能够看出来。在第二章回忆开展进程中说到了,OpenAI 在 2021 年就发布了专门针对代码的 CodeX 模型,将代码数据参加 GPT 的练习数据应该便是从那时开端的。

- 依照人的提问或许指令给予回复的才干:ChatGPT 除了能够用狭义的依据「问答」办法的交互以外,还能够依照输入的要求进行回复。例如,在应对「帮我写一封信」这类指令式的要求时,它相同也展示出了优异的才干。这种才干让它不仅是一个供给答案的「高级查找引擎」,更是一种能够用天然言语来交互的文字处理东西。

尽管现在群众普遍把目光聚焦在将 ChatGPT 作为一种类查找引擎的东西,但查阅相关常识并给予答复并不是它的仅有才干。实践上,单就 ChatGPT 自身而言,答复常识性的问题并不是它的强项,究竟它自身的练习数据被定格在了 2021 年。即运用更新的数据去练习,但它毕竟跟不上时势的变化,因而要将它用作常识性的问答东西,仍是需求与查找引擎等外部常识源做结合,就像现在 Bing 做的相同。

但换一个视点来看,ChatGPT 像是一个「言语齐备」的文本东西,也便是它能够依照你给它的要求,完结指定的、能够用文本办法表达出来的内容,就像下面这个比方。

依照给定的方案内容生成英文邮件进行汇报。

这儿所说的「言语齐备」,指的是运用言语的才干。能够看出上面这个比方里,其实不涉及常识性的内容,由于需求它写的内容现已供给给它了。但要写出这封邮件,涉及到的是运用言语的才干,比方遣词造句、语种切换、邮件格式等等。

现在咱们回过头来,测验剖析它的这种「依照指令完结使命」的才干是怎样取得的。在学界中,这种指令被称为 prompt,实践上对话中的用户输入、问答中的问题也是一种 prompt,因而能够浅显地了解为,在聊天框里输入的一切内容都是 prompt。假如了解咱们在本章榜首节介绍言语模型的内容,那么更谨慎一些的说法应该是「输入给模型的上文」都是 prompt。

ChatGPT 依据输入的指令(prompt)进行回复的才干,是来自于一种被称为指令微调的模型练习办法(prompt tuning)。其实原理很简略,模型仍然仍是「依据输入的内容,猜想下一个 token 是什么」,仅仅在指令微调的阶段,输入的内容被换成了这些事前写好的 prompt,而 prompt 后边需求生成的内容,则是事前写好的答案。因而在这一阶段和一开端所说的无监督自回归言语模型练习,最大的不同在于数据。这儿的数据,也便是 prompt 以及对应的回复,都是人写的,换句话说,这一阶段用的是人工标示的数据进行的监督练习。

说到人工标示的数据,就天然牵涉到了所需求的数据量了,由于每一条标示数据都是需求成本的。假如是不需求标示(就像榜首阶段的练习),那么天然有海量的文本数据可供练习,但假如要标示,那究竟需求多少这种数据呢?要知道,让标示人员手写一个 prompt,然后再手写一个几百字的、实在详尽的答复,成本是很高的。依据论文《Training language models to follow instructions with human feedback》的介绍,所需求的数据其实不需求太多(比较于无监督阶段所运用的数据来说)。尽管详细到 ChatGPT 究竟运用了多少没有切当的信息揭露,但能够确定的是在数量级上必定远比用来进行无监督练习的网页、百科和书本所构成的数据集要小十分多。

论文地址:https://arxiv.org/pdf/2203.02155.pdf

只需求相对少数的人工标示的 prompt 数据就能到达让模型依照指令做出回复的意图,这一点背后其实隐含了一个现象,在学界内被称为 prompt 的泛化才干。能够幻想一下,现在全世界都在不停的向 ChatGPT 提问,所提的问题也必定是千奇百怪的,这些问题其实便是一个个的 prompt。但用来对 ChatGPT 进行指令微调的 prompt 必定不会有这么多,这说明模型在学习到了必定量的 prompt 和相应的答案今后,它能够「举一反三」地对它没有见过的 prompt 进行答复,这便是 prompt 的泛化才干。文章《拆解追溯 GPT-3.5 各项才干的起源》剖析指出,这种泛化才干与在指令微调阶段让模型学习的标示数据数量以及多样性相关。

此外,用少数的 prompt 数据就能微调出相似于 ChatGPT 这样具有强大才干的模型,背后还隐含了另一个猜想,即模型所体现出来的各项才干,或许在无监督练习的阶段就现已存在于模型当中了。其实这也很好了解,究竟比较于无监督的数据,这些人工标示的 prompt 数量太少了,很难幻想模型是经过对这些仅有的标示数据学习而发生了各式各样的才干。从这个视点来说,指令微调的进程更多仅仅让模型学会按必定的标准来进行回复,而它的常识、逻辑等才干是早已存在的。

- 「客观公正」的才干:假如对 ChatGPT 问询一些有害或许有争议的问题,能够看到 ChatGPT 的答复都是十分「小心」的,很像是经过练习的新闻发言人般的答复。尽管它现在仍然做得不够好,但这种才干是 OpenAI 敢将它揭露作为一款产品运用的中心要素。

让模型的输出契合人类的价值观是 OpenAI 一向在做的作业。早在 2020 年 GPT-3 的时分,OpenAI 就发现这种经过网上的数据练习出来的模型,会生成带有歧视、危险、争议的内容。作为一个对外供给服务的产品,这些有害的内容显着是不适宜的。而现在的 ChatGPT 在这一点上有着显着的改进,让模型做出这种「行为改动」的主要办法也来自于 InstructGPT 的论文,更切当地说,是经过有监督的指令微调加上人类反应的强化学习共同完结的,这一点在第二章中也现已做过介绍了。

经过上述的剖析能够发现,从技能办法的视点来说,ChatGPT 相关的内容都是已知的,但为什么当时只要它具有如此冷艳的体现呢。实践上从 ChatGPT 推出之后,NLP 社区就一向在剖析这其间的原因,尽管许多结论是估测性的,但也为同类模型的国产化带来一些启示。

模型体量的要素

才干呈现呈现的前提是模型体量到达必定的规模,尽管没有详细的目标指引,但从现在的现实状况来看,相似于思想链等比较「高级」的才干,需求在数百亿参数量以上的模型中才体现得满足优异。

数据量的要素

模型的巨细不是仅有的要素。DeepMind 在这篇论文《Training Compute-Optimal Large Language Models》供给了一些剖析性的结论,指出练习的数据量需求跟着模型的体量相应地添加,更切当地说,是模型练习时「见过的 token」数量,需求跟着模型体量添加。

论文地址:https://arxiv.org/pdf/2203.15556.pdf

数据质量的要素

关于无监督的数据,数据量相对而言并不是很大的妨碍,但数据质量往往愈加简单被忽视。实践上在 GPT-3 的论文中,就有专门的内容介绍数据的处理作业。为了清洗 GPT-3 的练习数据,OpenAI 专门练习了一个数据过滤模型,来从海量的网页数据中获取更高质量的数据。比较而言,与 GPT-3 体量相当的一些开源模型,例如 Meta 的 Opt 和 BigScience 的 Bloom,好像没有进行这一步清洗。这或许是这两个开源模型作用劣于 GPT-3 的原因之一。

此外,数据质量的衡量维度不是单一的,比如数据的多样性、内容重复度以及数据的散布状况都是需求考虑的要素。例如尽管 GPT-3 所运用的网页、百科、书本这三大类数据中,网页数据的总量是最多的,但在练习时这三类数据的采样并不是依照实践数据的多寡进行的。

别的值得一提的是,在指令微调的阶段,选用人工编写指令或许是一个重要的影响要素。InstructGPT 的论文清晰指出在测评进程中,选用人工编写的指令练习出来的模型,比选用现有的 NLP 数据集经过模版的办法构建指令练习出来的模型有更好的作用。这或许解释了在 T0、FLAN 等由 NLP 数据集构成的指令数据集练习出来的模型为什么作用会差一些。

练习进程的影响

这类巨型模型在练习时经过集群进行练习,一起选用数据并行、模型并行以及 ZeRO 优化器(一种降低练习进程显存占用的办法),这些办法为练习的稳定性引进了更多的变量。如下这篇剖析指出乃至模型是否选用 bfloat16 精度都对成果有显着的影响。

剖析链接:https://jingfengyang.github.io/gpt

信任了解了上面的这些内容,咱们对复刻一个类 ChatGPT 的办法以及会面对的问题会有一个大致的了解。有幸的是 OpenAI 现已证明晰这技能途径是能够走通的,ChatGPT 的呈现也的确正在改动 NLP 技能的开展走向。

4、未来的展望

ChatGPT 从 2022 年 11 月上线以来,引起了极大的重视。信任即使是非专业范畴,乃至是与计算机也很少打交道的集体,或多或少地都知道它的存在,这个现象自身就现已反映出它的呈现有些不同寻常。圈外的群众更多的是以猎奇、惊讶或许惊叹的办法来感性地知道它的呈现。而对从业者来说,它的呈现更多的是对未来技能走向的思考。

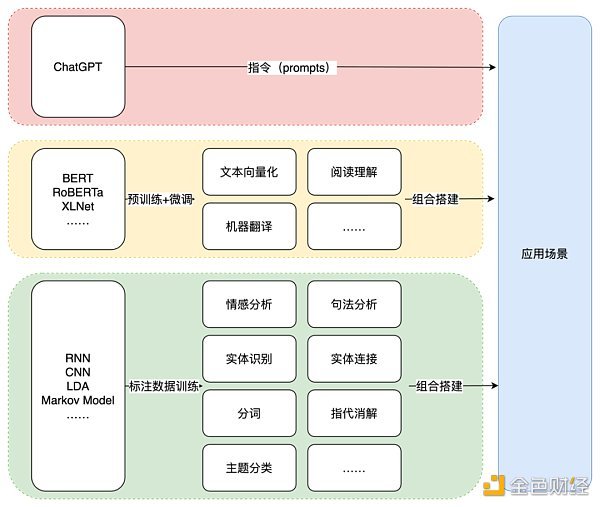

从技能的视点来说,ChatGPT 的呈现标志着 NLP 范畴的又一次范式切换。之所以说是「又」一次,是由于在 2018 年,也便是初代 GPT 发布的那一年,与之同年发布的 BERT 模型以自身优异的体现,创始了 NLP 的「预练习 + 微调」范式的年代,详细内容在第二章中现已做过介绍了。这儿主要介绍由 ChatGPT 敞开的「文本生成 + 指令」的范式。详细来说,便是使用练习好的 ChatGPT 或相似的文本生成模型,经过输入适当的指令(prompt)来完结某一项详细的场景。

这种范式与此前的 NLP 技能运用有很大的不同。不论是早期的使用 LDA、RNN 等统计模型或很小的深度学习模型的年代,仍是后来使用 BERT 等预练习合作微调的年代,技能所供给的才干是相对原子化的,间隔实践的运用场景有必定的间隔。

就拿前面举的让 ChatGPT 依据要求写英文邮件的比方,依照此前的做法,或许需求先抽取实体、事情等内容(比方时刻、地点、事情等),然后经过模版或是模型构成邮件的样式,再经过一个翻译模型转化为英文。当然假如数据量满足练习端到端模型的状况下,也能够跳过中心的若干步骤。但不论选用哪种办法,要么需求将最终的场景拆解成原子化的 NLP 使命,要么需求对应的标示数据。而关于 ChatGPT 来说,只需求一个适宜的指令。

三个阶段的 NLP 技能范式。

这种生成式模型搭配 prompt 的办法,直接略过了中心的各项 NLP 才干组件,用最直接的办法处理运用场景的问题。在这种范式下,完结终端运用的技能途径将不再是用单点 NLP 才干模块经过搭积木的办法组合起来。

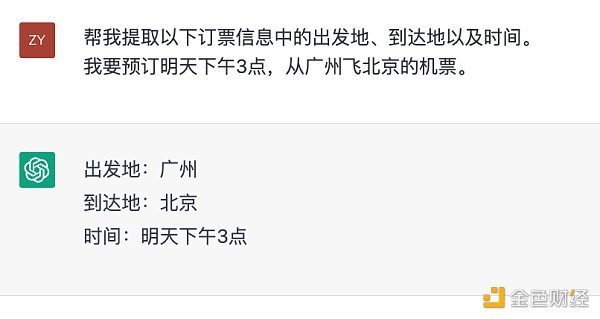

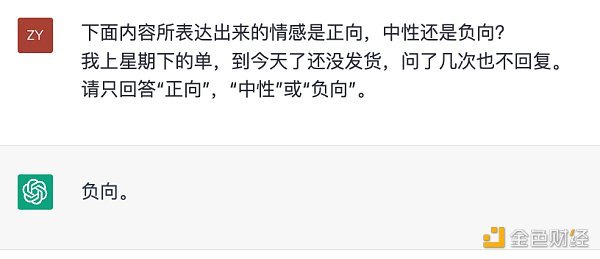

当然,这个进程不是一蹴即至的,也不意味着 NLP 的单点才干变得不重要。从测评的视点来说,每一个单点才干的好坏仍然可作为点评模型作用的目标。而且,就某些场景来说单点才干依旧是一个强需求。例如在订票体系中自身就需求针对时刻、地点进行提取。但与此前不同的是,ChatGPT 自身也能够完结单点才干,而不需求运用额定的功用模块。

ChatGPT 进行信息提取。

ChatGPT 进行情感判别。

从这个视点来说,能够把 ChatGPT 看作是一个以天然言语作为交互前言的 NLP 东西。假如说在曩昔,咱们是经过模型 + 数据 + 规划练习使命的办法来完结某项 NLP 才干,那么 ChatGPT 则是经过规划指令来完结这些才干。

可想而知,ChatGPT 的呈现大大降低了 NLP 技能的运用门槛。但它现在还不是万能的。最重要的一点在于它缺乏精确牢靠的垂直范畴常识,为了让它的答复牢靠,最直接的办法是为它供给外部的常识来历,就像微软将 Bing 的查找成果作为它答复的信息来历那样。

因而,「传统」的 NLP 技能并不会就此完全消亡,而是会以「辅助」的人物,作为现在 ChatGPT 短板的弥补,这或许会是未来 NLP 技能运用的新范式。

此时快讯

【2023-02-24 15:03】【艺电创始人将担任Web3游戏公司Games for a living首席战略官】金色财经报道,游戏巨头艺电(Electronic Arts)创始人William Murray “Trip” Hawkins III将担任巴塞罗那Web3游戏初创公司Games for a living的首席战略官(CSO)。(CoinDesk)